نحوه یادگیری زبان انگلیسی با پادکست

در ابتدا باید خلاصه فارسی این پادکست انگلیسی با متن و ترجمه فارسی را مطالعه کنید تا با موضوع کلی محتوای پادکست آشنا شوید. سپس صوت را پخش کنید و همراه با متن گوش کنید و مشاهده کنید. یک بار کامل گوش کنید و سعی کنید تا حد امکان متوجه موضوعات بشوید. در پایان لغات جدیی که بلد نبودید را پیدا کنید و یادبگیرید. حالا دوباره پادکست را با متن گوش کنید و ببینید. شیوه یادگیری را به ترتیب برای شما در زیر نوشتهایم حتما طبق آن پیش بروید.

- مطالعه خلاصه فارسی پادکست

- گوش دادن به پادکست همراه با مشاهده متن انگلیسی

- پیدا کردن و یادگیری لغات جدید

- گوش دادن مجدد به پادکست همراه با متن انگلیسی

- گوش دادن به پادکست بدون متن

- پاسخ به آزمون مربوط به پادکست

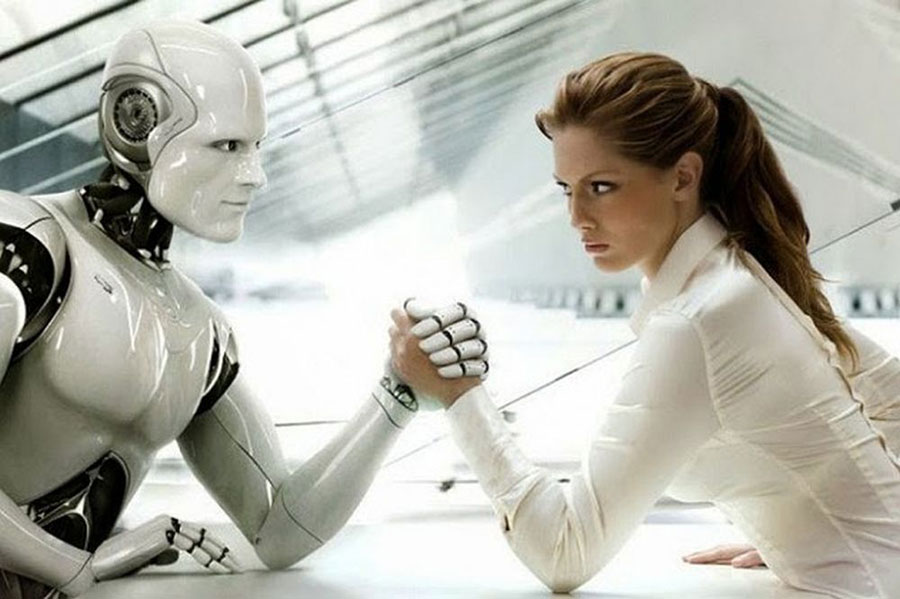

خلاصهای از پادکست انگلیسی خطرات هوش مصنوعی در انتخابات

در انتخابات ریاست جمهوری آمریکا سال ۲۰۲۴، ریسک تأثیر اطلاعات نادرست بر رأی دهندگان وجود دارد. ابزارهای هوش مصنوعی جدید که به صورت رایگان در دسترس عموم قرار میگیرند، میتوانند اطلاعات جعلی را به رأی دهندگان ارائه کرده و به کاندیداها کمک کنند. این ابزارها میتوانند خبرهای جعلی، ویدیوها و تصاویری که به نظر واقعی میرسند، تولید کنند. در حال حاضر، سیستمهای هوش مصنوعی قادر به تولید صداها، تصاویر و ویدیوهای جعلی هستند و هزینه تولید آنها نیز کم است. این ابزارها میتوانند پیامهای جعلی را در اشکال مختلفی ایجاد کرده و در رسانههای اجتماعی یا وبسایتهای خبری جعلی منتشر کنند تا به گروههای خاصی از مردم تأثیر بگذارند. به عنوان مثال، پیامهای تلفنی با صدای جعلی کاندیدا میتوانند رأی دهندگان را درباره تاریخ درست رأیگیری گمراه کنند. همچنین، مکالماتی میتوانند ساخته شوند که کاندیدا اعتراف به جرمی میکند یا عقاید نژادپرستانهای را بیان میکند. ویدیوها نیز میتوانند به نظر برسند که کاندیدا سخنرانی یا نظریهای را اعلام کرده است که در واقع هرگز نگفته است. از تصاویر جعلی نیز میتوان استفاده کرد تا به نظر برسد یک گزارش خبری محلی کاندیدا از رقابت خارج شده است. افراد مانند سازمانهای بینالمللی یا دولتها از ابزارهای هوش مصنوعی برای تقلید یک سیاستمدار آمریکایی استفاده کنند. در این موارد، نمیتوان تضمین کرد که مقامات یا نیروهای انتظامی آمریکا قادر به انجام اقداماتی باشند.

در مجلس نمایندگان آمریکا قانونی معرفی شده است که از نامزدها میخواهد تبلیغات انتخاباتی ساخته شده با هوش مصنوعی را شناسایی کنند. برخی ایالتها نیز پیشنهادهای خود را برای کاهش استفاده از محتوای جعلی تولید شده توسط هوش مصنوعی ارائه کردهاند.

با این حال، استفاده از هوش مصنوعی برای ایجاد مطالب نادرست و گمراهکننده در صدا، ویدیو و متون وابسته به هوش مصنوعی نیست. نماینده نیویورک، اما میگوید بزرگترین ترس او این است که ابزارهای هوش مصنوعی قبل از انتخابات سال ۲۰۲۴ برای ایجاد مواردی که به خشونت و تقسیم آمریکاییها منجر میشود، استفاده شود.

وی به اهمیت راهبردی بودن با فناوری همراه بودن میاندیشد و میگوید: “مردم مشغول زندگی خود هستند و وقتی ندارند هر اطلاعاتی را بررسی کنند. هوش مصنوعی که در سیاست به عنوان ابزاری به کار گرفته شود، میتواند بسیار مخرب باشد.”

The risk of misinformation influencing voters has long existed during elections around the world. But political experts warn that new artificial intelligence (AI) tools may create even more problems during the 2024 American presidential election.

Newly released AI tools are widely available at no cost to the public. Such tools can be used to present voters with false, or fake, information in an effort to help candidates, experts say.

Misinformation can take many forms, including fake news stories that seem real. Voters can also be targeted with high-quality video or audio that appear to show real candidates, but which were actually created by machines.

Today, AI systems can quickly produce fake voices, images and videos in seconds. And they can be created for little or no cost to the users. The tools, described as “generative AI,” have received wide attention since the launch of ChatGPT late last year.

Technology experts say these kinds of AI tools can be used to invent false messages in a series of different forms. The material can then be published to social media services or fake online news websites. Such material can be effective because it can target specific groups of people.

“We’re not prepared for this,” said A.J. Nash, vice president of intelligence at the internet security company ZeroFox. “To me, the big leap forward is the audio and video capabilities that have emerged,” Nash told The Associated Press.

AI experts have identified possible situations in which AI could be used to trick the voting public. Among these are AI generated phone messages that seem to be in a candidate’s own voice. Such messages could misinform voters about the correct voting date.

Fake voice recordings could also be created to show a candidate admitting to a crime or expressing racist opinions. Video could also appear to show candidates giving a speech or comments they never gave. False images could be designed to look like local news reports that claim a candidate dropped out of the race.

Former President Donald Trump, who is running for president in 2024, has shared AI-generated content with his followers. Recently, Trump shared a manipulated video of CNN news presenter Anderson Cooper on his Truth Social service.

Another example of what AI tools can do is a campaign advertisement released last month by the Republican National Committee (RNC). The online ad came after Democratic President Joe Biden officially announced his reelection campaign.

The ad began with an image of Biden and the words, “What if the weakest president we’ve ever had was re-elected?” The ad then showed a series of AI-created images. These included Taiwan under attack, closed businesses in the U.S. and soldiers and military vehicles driving down streets.

RNC officials confirmed the use of AI in the ad. But other individuals or groups will likely develop and release such material in secret, said Petko Stoyanov. He is chief technology officer at Forcepoint, an internet security company in Austin, Texas. Stoyanov predicted groups aiming to interfere with U.S. democracy will employ AI tools and fake media material to reduce the public’s trust.

He gave the example of international organizations, overseas criminals or states using AI tools to impersonate an American politician. In such cases, Stoyanov said, he is unsure U.S. officials or law enforcement could do anything about it.

Legislation has been introduced in the U.S. House of Representatives to require candidates to identify campaign ads created with AI. Some states have offered their own proposals aimed at reducing the use of fake AI-generated content.

AI is not necessarily needed, however, to create false or misleading audio, video or written materials.

However, New York Representative Yvette Clarke said her biggest fear is that AI tools could be used before the 2024 election to create material that incites violence and turns Americans against each other.

“It’s important that we keep up with the technology,” Clarke told the AP. “People are busy with their lives, and they don’t have the time to check every piece of information. AI being weaponized, in a political season, it could be extremely disruptive,” she said.

Words in This Podcast

لغات مهم این پادکست

leap – n. a big jump

emerge – v. to become known

manipulate – v. to control someone in a way that makes them do what you want to do

impersonate – v. to copy the way someone looks and behave

disrupt – v. to block something and stop it from continuing as it should

Quiz – AI Tools Present New Risks in Election

آزمون پادکست انگلیسی خطرات هوش مصنوعی در انتخابات

The story says all of the listed forms of misinformation will be possible using newly-developed AI tools.

Yvette Clarke expressed a fear that AI would become “weaponized” during the next U.S. political season.

The story says the Republican National Committee released an AI-generated video after President Joe Biden announced his reelection campaign.

A.J. Nash said he thinks audio and video capabilities have experienced “a big leap forward” in recent years.

دیدگاهها (0)